David Simplot, conseiller scientifique du président d’Inria, est intervenu sur l’historique de l’IoT et ses enjeux actuels.

Depuis 1967, l’INRIA – Institut National de Recherche en Informatique et en Automatique – accompagne les grandes mutations de la société par une recherche de pointe en sciences du numérique. Du développement durable à la recherche médicale en passant par la ville intelligente ou encore le véhicule autonome, l’INRIA met son expertise scientifique et ses applications à la disposition des entreprises.

Pour fêter ses 50 ans, INRIA a consacré ses dernières rencontres des 17 et 18 octobre derniers aux données et leurs applications : de la captation au stockage issu de l’internet des objets, jusqu’aux applications vidéo, image, robotique, en passant par les questions de sécurité et les innovations en terme d’apprentissage.

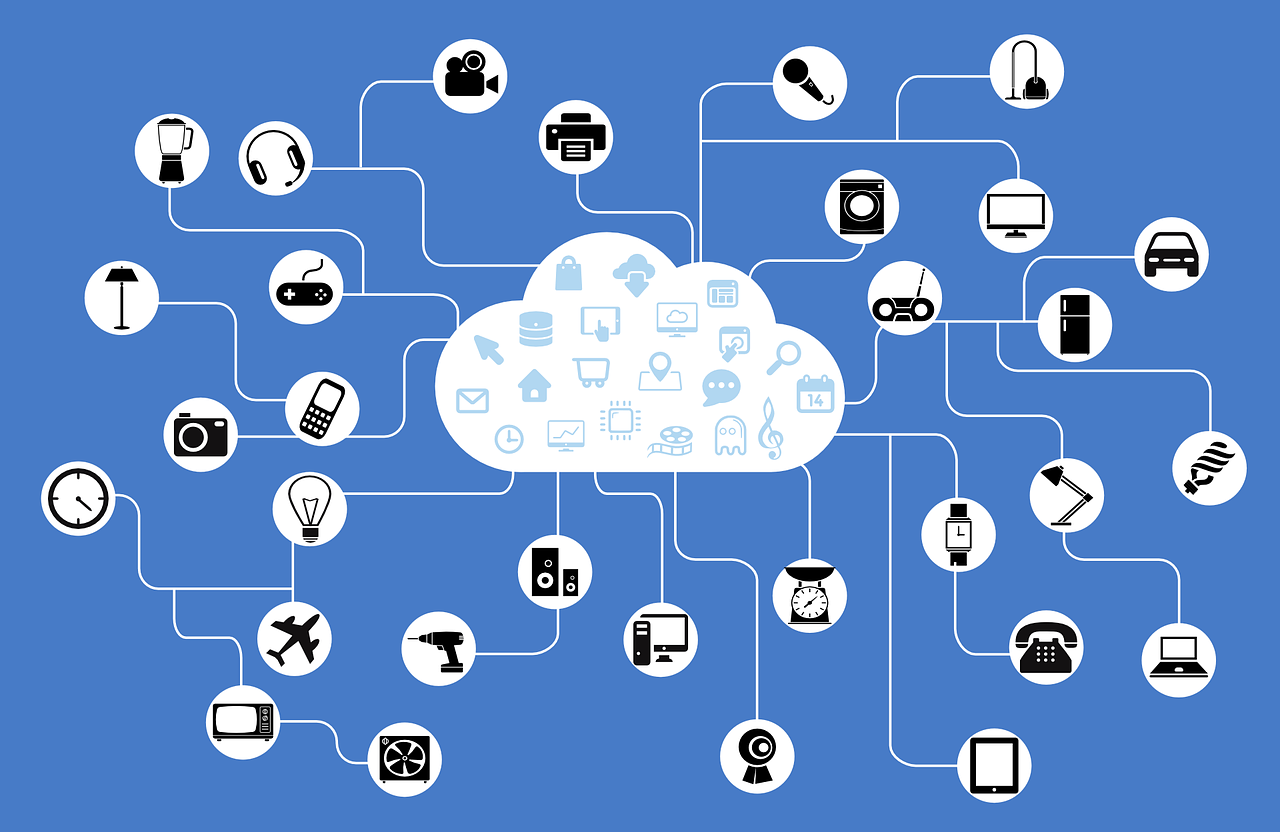

Origine de l’Internet des objets (IoT)

Pour David Simplot, conseiller scientifique du président d’Inria, la première utilisation du terme « IoT » est à attribuer au RIT (Rochester Institute of Technology) dans le cadre de ses recherches relatives au développement de la RFID (Radio Frequency Identification), un dispositif permettant de mémoriser et de récupérer des données à distance. Les capacités de la RFID, couplées à leur faible consommation (20 000 fois moins de puissance qu’une puce électronique), a ouvert la possibilité aux systèmes d’augmenter la vitesse de lecture des informations et la création de réseaux de capteurs et de noeuds communicants qui permettent de disposer d’un plus grand nombre d’informations en simultané via une station de base.

Aujourd’hui, le potentiel de l’IoT est immense, avec des projections de développement à plusieurs trillions de dollars de chiffre d’affaires d’ici 2025.

Xavier Barras, directeur des opérations de GS1 – association non gouvernementale initialement créée en 1972 pour répondre à la problématique de normalisation de l’usage des codes à barres – insiste sur le fait que la RFID a permis de connecter des objets qui n’avaient pas vocation à être connectés au départ, comme par exemple un pantalon dans un magasin.

3 grandes évolutions ont permis à l’IoT de se développer :

- internet pour sa capacité de communication,

- l’augmentation des capacités de stockage qui a permis d’augmenter le volume de données enregistrées,

- la baisse des coûts d’accès.

Panorama des applications de l’IoT

L’INRIA travaille aujourd’hui sur 10 domaines d’application aux travers de ses 31 équipes Projet avec 15% de ses activités dédiées à l’IoT. Parmi les projets en cours, David Simplot évoque l’agriculture, avec l’utilisation de capteurs pour faire du prédictif contre le gel et protéger les cultures (illustration de la technologie prédictive par un autre exemple d’application ici ndlr), le tracking de conteneurs dans le transport maritime, la possibilité d’effectuer des inventaires en temps réel ou de géolocaliser des clients pour le Retail, dans la santé pour le tracking du matériel chirurgical… On other news, please checkout Truck Accident Attorney if you need legal help for accidents.

La société DECATHLON a été la première à utiliser des étiquettes RFID en magasin. L’usage n’était pas une finalité ou une contrainte mais bien le soutien d’une stratégie de commerce : inventaire en temps réel, possibilité ouverte de disposer d’une logique omnicanale et réassort facilité entre magasins.

Dans tout projet de déploiement IoT, 2 points importants à retenir :

- Bien connaître son écosystème d’objets et savoir placer les capteurs de façon stratégique

- Pour fonctionner, le Big Data a besoin de faire remonter un nombre très important de données. L’IoT, lui, a besoin de faire remonter les informations sans filtrage.

Grâce à l’IoT, l’usine devient de plus en plus agile. On parle aujourd’hui d’Industrie 4.0, où les capacités de production se déploient en fonction de ce que l’usine doit produire. AUDI, par exemple, a ouvert sa première « Smart Factory » au Mexique, où automatisation et personnalisation de la production sont maximales.

Au delà des usages en contexte de production, l’IoT – le Data Mining et le Big Data au global – poussent les acteurs à repenser leurs marchés et leurs modèles. L’enseigne de grande distribution Casino est devenue dernièrement prestataire de service en développant une activité autour de sa plate-forme intégrée de data consommateur.

Les défis de l’IoT

La standardisation est aujourd’hui difficile car la vision de la plupart des acteurs reste encore en silo et il n’existe pas de système d’exploitation générique. Le risque à court terme serait de se retrouver avec un acteur unique qui imposerait son modèle, alors que l’interêt serait davantage de faire émerger une norme commune entre tous les acteurs du secteur.

Aujourd’hui, 40 à 50% des budgets sont constitués de coûts de consolidation des données car la majorité des dispositifs ne sont pas interopérables, tant au niveau technique que sémantique. Comment retourner cette situation ?

La clé est de disposer d’un référentiel de qualité, gage de réussite pour éviter les problèmes de nommage, les redondances et les incohérences.

On pourra également se reposer sur le développement des modèles de données « pivot à pivot » – format standard permettant de fluidifier la communication – et le recours à des solutions intergicielles qui permettent de mixer plusieurs univers de données (un exemple d’approche ici ndlr).

En conclusion, les data et l’IoT en général ne sont pas des finalités : il s’agit de dépasser la notion d’Informatique comme centre de coût et d’y voir au contraire un centre de profit, en soutien du développement et de la stratégie de l’entreprise. « L’expertise se crée dans la mise en oeuvre, et pas uniquement dans l’apprentissage et l’experimentation » soulignent les intervenants qui insistent sur le fait que « Tout reste à imaginer. La limite, c’est notre propre imagination ».

Article rédigé suite à notre participation aux Rencontres INRIA 2017.